Machine learning e data fusion con dati telerilevati

Come sfruttare l’informazione contenuta nella grande varietà di sorgenti eterogenee disponibili al giorno d’oggi

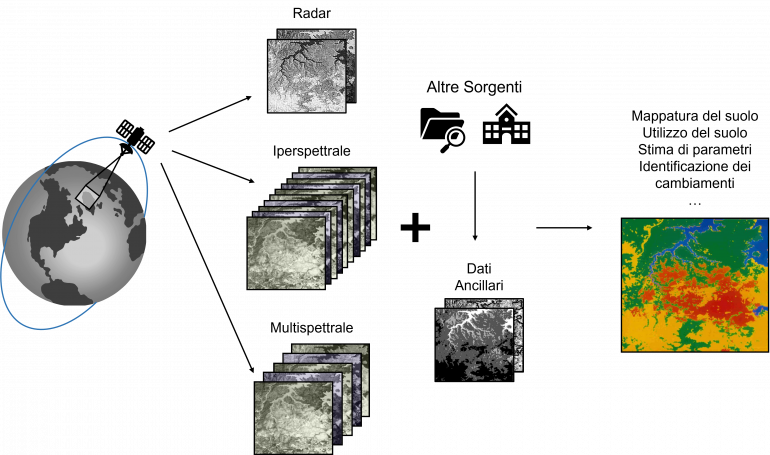

L’Università di Genova, e in particolare il laboratorio IPRS (Image Processing and Pattern Recognition for Remote Sensing), da diversi anni si occupa di sviluppare metodi automatici innovativi nell’ambito del machine learning e del data fusion applicato a dati e immagini telerilevate. Nel campo del telerilevamento, come d'altronde in molti altri settori (ad esempio, visione artificiale, sistemi autonomi), la crescente disponibilità di dati a livello globale rende molto complessa la scelta di quale sorgente informativa utilizzare per ottenere un determinato prodotto di interesse.

Un esempio è rappresentato dalla generazione di mappe di copertura del suolo in determinate aree del pianeta. Questo può essere fatto manualmente, sia visitando fisicamente tali zone di interesse e catalogando ciò che è presente, oppure interpretando visivamente immagini acquisite da camere montate su satelliti, aerei, droni, etc. È tuttavia molto semplice notare che una simile attività sia molto onerosa dal punto di vista dello sforzo richiesto, del costo, e del tempo necessario per produrre una singola mappa.

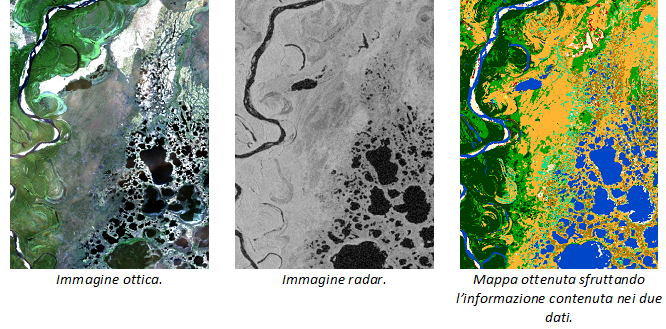

Al giorno d’oggi, per una determinata zona del pianeta, può essere disponibile una moltitudine di immagini eterogenee (ad esempio, immagini ottiche e radar). Metodi automatici che le elaborino in autonomia in modo accurato ed efficiente sono quindi di fondamentale importanza. Sfruttando le capacità computazionali dei recenti computer, è possibile sviluppare metodi che siano in grado di integrare tutte queste sorgenti e produrre risultati che tengano conto di tutta l’informazione disponibile e delle caratteristiche dei dati utilizzati. Ad esempio, la capacità dei dati radar di rappresentare una zona indipendentemente dall’illuminazione e dalle condizioni climatiche (sia di giorno sia di notte o malgrado la presenza di nuvole) o la risoluzione spaziale e spettrale offerta dai recenti sensori ottici multi- e iper-spettrali.

L’applicazione a tematiche importanti quali il cambiamento climatico

In questo contesto, di particolare interesse è il progetto “High Resolution Land Cover - Essential Climate Variable,” finanziato all’interno del programma “Climate Change Initiative Extension” dell’Agenzia Spaziale Europea e tra i cui partner è presente l’Università di Genova con il laboratorio RIOS (Remote Sensing for Environment and Sustainability).

L’obiettivo principale del progetto è studiare e analizzare la correlazione tra i cambiamenti climatici degli ultimi decenni e l’evoluzione della copertura del suolo in tre aree di fondamentale importanza per il pianeta: l’Amazzonia, la Siberia, e il Sahel. I prodotti necessari per lo studio (mappe di copertura del suolo e mappe di cambiamento) sono generati con metodi automatici di machine learning e data fusion che permettono di sfruttare una moltitudine di dati raccolti negli anni da diversi satelliti per l’osservazione della Terra.

Collaborazione con il Goddard Space Flight Center

Tra le molte collaborazioni importanti dei laboratori IPRS e RIOS vi è quella con il Goddard Space Flight Center della NASA, uno dei maggiori laboratori relativi alle scienze dello spazio. Negli ultimi anni, studenti magistrali in Ingegneria delle Telecomunicazioni (Internet and Multimedia Engineering) hanno avuto la possibilità di svolgere degli internship presso questo centro riuscendo ad ottenere ottimi risultati come articoli scientifici pubblicati nelle più importanti conferenze e riviste internazionali del settore.

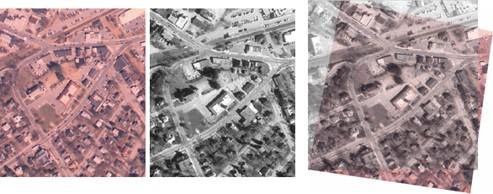

Uno dei lavori più recenti ha anche portato alla concessione di un brevetto, l’US10825182B1 intitolato "System and method of crater detection and registration using marked point processes, multiple birth and death methods and region-based analysis". Il focus del brevetto è lo sviluppo di un metodo automatico di registrazione di immagini. In breve, quando sono disponibili immagini raffiguranti uno stesso soggetto, ma acquisite da sensori diversi, o in diversi momenti, o da diversi punti di vista, queste immagini devono essere trasformate in modo che condividano lo stesso sistema di riferimento prima di poter essere elaborate congiuntamente. Tale procedimento prende il nome di registrazione.

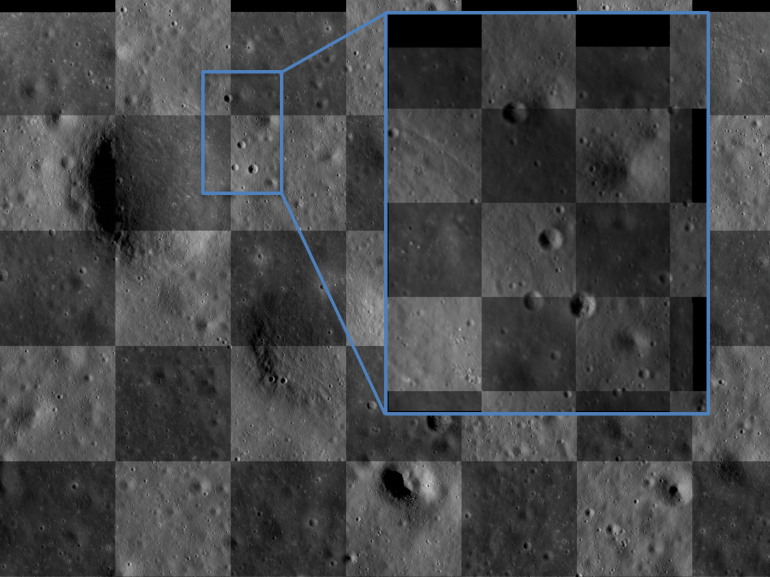

Il metodo brevettato ha lo scopo di registrare immagini planetarie e, per fare ciò, sfrutta l'identificazione automatica e il matching dei crateri presenti sulla superficie del pianeta (o del satellite) di interesse. L’immagine qua sotto mostra un esempio dei risultati ottenuti. Le due immagini registrate sono mostrate nei riquadri alternati di una scacchiera: il fatto che non si notino discontinuità sui bordi dei riquadri mostra come le due immagini combacino grazie all’elaborazione svolta dal metodo.

Altri campi di applicazione

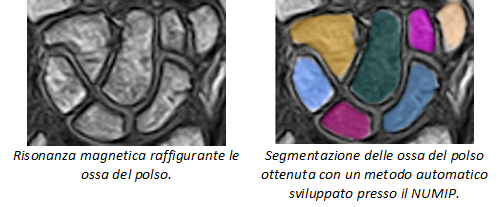

Queste metodologie trovano applicazione anche in altri ambiti. Ad esempio, i laboratori NUMIP (Numerical Image Processing) e A3US (Acoustics, Antenna Arrays, and Underwater Signals) operano nel campo biomedicale e nel campo dell’acustica. Tra i lavori più interessanti possiamo citare lo sviluppo di metodi automatici per l’elaborazione di immagini mediche (ad esempio, ultrasuoni, risonanza magnetica), a supporto dei professionisti in campo medico, e la stima (o la predizione) di parametri ambientali (ad esempio, intensità di vento e pioggia) a partire da misure di rumore acustico subacqueo.

David Solarna è Assegnista di ricerca presso il DITEN