Nasce InfoAICert: un progetto per la certificazione delle AI ad alto rischio

L'AI Act sui sistemi di AI ad alto rischio

Le tecnologie basate sull'intelligenza artificiale stanno diventando onnipresenti, le loro applicazioni e prestazioni stanno crescendo a un ritmo senza precedenti e i benefici socioeconomici attesi sono enormi.

L'attenzione della comunità scientifica e degli stakeholder è focalizzata da tempo sugli usi benefici dell'AI. Meno attenzione è stata prestata ai potenziali usi impropri, agli usi dannosi e alla mancanza di robustezza dell'AI che potrebbero compromettere la sicurezza degli individui e della società.

Il Parlamento europeo ha votato in plenaria la proposta della legge europea sull'intelligenza artificiale (AI Act) nel giugno 2023 e dovrebbe essere in vigore alla fine del 2026 con l'obiettivo di preservare i benefici delle tecnologie basate sull'AI e ridurre i rischi per i cittadini europei.

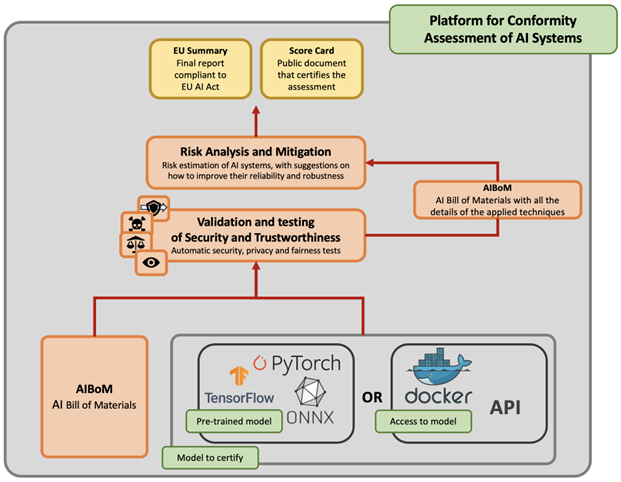

L'AI Act identifica i sistemi di AI ad alto rischio che possono accedere al mercato dell'UE solo dopo una "valutazione della conformità" (una sorta di marchio CE per l'AI) che convalida e verifica la sicurezza e l'affidabilità del sistema di AI. Per esempio, l'allegato III della legge sull'AI dell'UE considera i sistemi di identificazione delle persone fisiche come sistemi ad alto rischio.

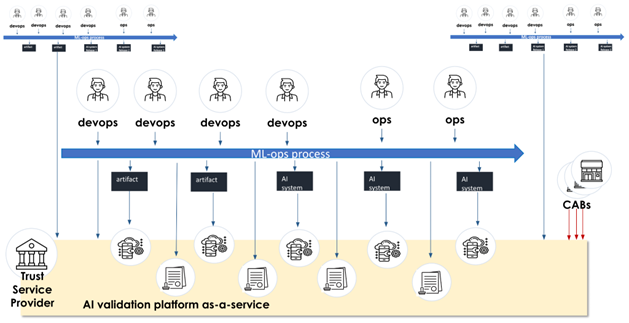

I fornitori e i produttori di sistemi di AI ad alto rischio avranno la necessità di fornire agli organismi di valutazione della conformità tutta la documentazione necessaria per accedere al mercato dell'UE. Le aziende che vendono sistemi di AI non classificati come ad alto rischio saranno comunque motivate a sottoporsi alla valutazione di conformità, in quanto si tratta di una buona pratica chiaramente raccomandata dall'AI Act dell'UE. Questo creerà un'enorme domanda di mercato dato che il 77% delle aziende nel mondo sta prendendo in considerazione l'uso di sistemi di intelligenza artificiale.

Purtroppo, la legge sull'AI dell'UE fornisce prescrizioni, ma non linee guida pratiche e strumenti tecnici per la valutazione della conformità in linea con la legge.

Il progetto InfoAICert

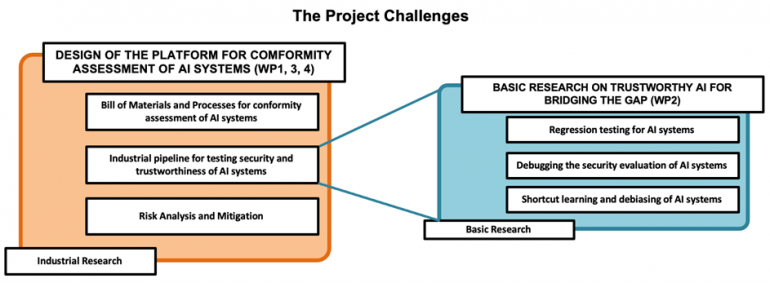

La visione di InfoAICert è che la domanda del mercato di prodotti e servizi innovativi per la valutazione della conformità dei sistemi di AI esploderà dopo il 2026: per trarre vantaggio da questa futura domanda del mercato è necessario far progredire la ricerca di base e fare una notevole quantità di nuove ricerche industriali nei prossimi anni.

L'obiettivo e l'ambizione del progetto InfoAICert sono di sviluppare la prima piattaforma made in Italy per la valutazione della conformità di sistemi di AI ad alto rischio: il progetto consentirà l'offerta di servizi innovativi a tutti i produttori che dovranno certificare la conformità dei loro sistemi di AI per accedere al mercato dell'UE.

Questo consentirà all'industria italiana di ottenere un forte vantaggio competitivo essendo in grado di fornire un servizio di valutazione della conformità ai suoi attuali clienti e a molti altri fornitori e produttori di sistemi di AI dell'UE. Attualmente sul mercato non è disponibile alcun servizio di questo tipo.

Sicurezza e affidabilità delle IA

Il progetto InfoAICert - A Platform for Conformity Assessment of AI Systems with the EU Artificial Intelligence Act è finanziato dal Fondo Italiano per le Scienze Applicate nell’ambito di intervento Artificial Intelligence, con il quale il Ministero dell’Università e della Ricerca sostiene progetti di ricerca industriale e sviluppo sperimentale presentate da singoli ricercatori (Principal Investigator) che mostrino spiccate caratteristiche di originalità e innovatività e siano al contempo in grado di favorire ricadute socioeconomiche e industriali. (incluso un migliore accesso e utilizzo dei dati scientifici).

Principal Investigator del progetto è Fabio Roli del Dipartimento di Informatica, Bioingegneria, Robotica e Ingegneria dei Sistemi dell'Università di Genova, in collaborazione con l'impresa Tinexta/InfoCert, che sarà la Host Institution del Principal Investigator. Il budget del progetto è di 5.557.500€ per una durata quinquennale.

L’Università di Genova parteciperà al progetto con il suo laboratorio sAIfer diretto da Fabio Roli. Il sAIfer Lab si occupa di sicurezza ed affidabilità dell’Intelligenza Artificiale.

InfoCert è una multinazionale del software che fornisce servizi digitali sicuri alle aziende e fa parte del gruppo Tinexta, un'azienda tecnologica con un alto tasso di crescita. Il gruppo Tinexta opera su Digital Trust, Cyber Security, Business Innovation.